Desde la guadaña hasta el motor de vapor, siempre hemos usado la tecnología para controlar al mundo que nos rodea.

Pero nuestra habilidad para modelar nuestro entorno fue transformado por una máquina quizás más que cualquier otra: la computadora.

Lo que hace a las computadoras poderosas es el código: es increíblemente flexible, de manera que puede controlar desde juegos hasta naves espaciales.

Llegó a serlo gracias a individuos geniales, invenciones que brotaron de la necesidad y el poder de la imaginación humana.

1679 - Binario: el lenguaje de las computadoras

La raíz del mundo digital de hoy en día tiene sus orígenes en una idea sencilla de hace tres siglos: el código binario.

Los humanos hemos creado códigos desde las épocas antiguas. Pero fue un matemático alemán el que se inventó el código que apuntala casi toda la computación en la actualidad.

Gottfried Liebniz creó un sistema que no utilizaba los diez dígitos normales, 0 al 9, sino sólo dos: el 0 y el 1.

Lo llamó "binario" y se imaginó una calculadora mecánica en la que unas bolitas podían caer por un hueco para representar al 1 o quedarse por fuera cuando el hueco estuviera cerrado, para representar al 0.

La calculadora nunca se fabricó, pero la idea de Liebniz allanó el camino para la informática.

1804 - El telar de Jacquard: máquinas controladas por cartón

Más de un siglo después de que Leibniz inventara el sistema binario, un tejedor francés lo usó para cambiar la forma en la que hacía textiles. José Jacquard inventó un telar automático con motor de vapor.

La guía eran pedazos de cartón que contenían filas de huecos. La presencia o ausencia de un hueco en cada posición programaba al telar a tejer cierto patrón. Una tarjeta distinta hacía que el telar produjera un patrón distinto.

Las tarjetas eran en efecto las instrucciones para el telar: un antecesor a los programas de computador modernos.

1842-1843 - Babbage y Lovelace: la primera idea del hardware y software

Ada Lovelace fue una matemática inglesa que se adelantó en el tiempo al describir cómo programar una máquina calculadora mucho antes de que las computadoras fueran desarrolladas.

El también matemático británico Charles Babbage llevó la idea de Jacquard más lejos y diseñó el Motor Analítico: la primera calculadora de uso general.

La idea de Babbage era que las tarjetas perforadas alimentarían con números y con las instrucciones sobre qué hacer con esos números a la máquina.

Eso hizo que la calculadora fuera increíblemente flexible.

En 1842, su colega Lovelace describió exactamente cómo las tarjetas perforadas podían programar el Motor Analítico para que hiciera un cálculo específico.

Aunque la calculadora nunca fue construida y por ende su programa nunca fue probado, Lovelace se llevó el crédito de ser la primera programadora de computador de la historia.

1890 - La máquina de censo de Hollerith: el nacimiento de big data

El censo de Estados Unidos al final del siglo XIX representaba una pesadilla administrativa. Iba a tomar ocho años registrar manualmente los datos de cada ciudadano.

Un oficinista llamado Herman Hollerith encontró la solución. Se dio cuenta de que podía adaptar las tarjetas perforadas de Jacquard y Babbage usando la nueva tecnología de la electricidad.

La información del censo de cada persona era codificada en una tarjeta. Con unos alfileres se presionaba sobre la tarjeta y si pasaban por un hueco, se completaba un circuito eléctrico que se registraba.

Hollerith tornó su invento en un negocio, que más tarde llegó a ser la firma de computadores IBM.

1923 - Enigma: matemáticas para guardar secretos militares

La idea de usar electricidad para cifrar fue aprovechada por los militares. Al final de la Primera Guerra Mundial, el ingeniero alemán Arturo Scherbius diseñó la máquina Enigma, que podía cifrar y descifrar mensajes secretos codificados.

Pronto estuvo disponible comercialmente y le siguieron otros modelos más complicados.

El código Enigma fue usado por la Alemania nazi en la Segunda Guerra Mundial y descifrado por matemáticos británicos que trabajaban en Bletchley Park, como Alan Turing.

Se le acredita a la capacidad de los aliados de descodificar los mensajes alemanes el haber acortado la guerra por dos años.

1936 - La máquina universal Turing: una computadora multipropósito

Las primeras máquinas de computador como Enigma estaban programadas para cumplir con sólo un tipo de tarea.

Alan Turing se propuso hacer una máquina que pudiera hacer más.

La describió como una máquina flexible que seguiría las instrucciones de un largo pedazo de cinta, lo que sería el equivalente de la memoria de una computadora moderna.

Como los patrones cifrados en la cinta podrían ser cambiados fácilmente, la máquina sería capaz de hacer casi cualquier tarea.

Aunque esto suena como una idea simple hoy en día, en esa época era un concepto radical.

1948 - El "Baby" de Manchester: la primera computadora electrónica

Aunque Turing tuvo la visión de una computadora multipropósito, confeccionar una memoria vasta de instrucciones en una cinta de papel no era una solución práctica.

En 1948, un equipo de ingenieros en la Universidad de Manchester encontró la manera de guardar memoria usando cargas eléctricas, una técnica inspirada en los equipos de radares de la guerra.

Eso les permitió construir la primera computadora para propósitos generales que funcionaba: la Manchester Small Scale Experimental Machine (la máquina experimental a escala pequeña de Manchester).

La llamaban "Baby", estaba programada con código binario, contenía 128 bytes de memoria y ocupaba una habitación entera.

1951 y 1961 - La computadora se torna musical y juguetona

La "Baby" pronto se convirtió en el prototipo para la primera computadora electrónica para uso general que se vendió comercialmente: la Ferranti Mark 1.

Incluía un programa musical fue escrito por un amigo de Alan Turing, el científico Christopher Strachey.

Tras demostrar que podían hacer música, las computadoras se empezaron a usar para crear la primera forma de entretenimiento interactiva.

En 1961, a tres jóvenes programadores de MIT les dieron la oportunidad de experimentar con una computadora inusualmente pequeña, la PDP-1 (del tamaño de dos refrigeradores).

Lo que crearon fue "Spacewar!", el que ahora muchos consideran como el primer videojuego verdadero.

Dos jugadores, cada uno controlando una nave espacial, tenían la tarea de destruir al otro mientras orbitaban una estrella. El juego introdujo muchos de los conceptos que le son familiares a los aficionados de hoy, entre ellos la acción en tiempo real y los disparos.

1966 - Los computadores de Nasa: el software que nos lleva al espacio

Cuando empezaron a introducirse nuevos computadores más pequeños en el diseño de otras máquinas, se abrió la posibilidad de viajar al espacio.

El sistema Computador de Navegación del Apolo fue diseñado por el programa espacial de Nasa de Apolo. Fue usado por primera vez en 1966, y en cuestión de tres años le ayudó a Neil Armstrong y Buzz Aldrin a llegar a la superficie de la Luna.

Con sólo 74KB de memoria -menos que una calculadora de hoy en día- era capaz de controlar una nave espacial de 13.000 kilogramos, que viajó a 3.500 km/h alrededor de la Luna, alunizó sin problemas y regresó a la Tierra.

1971 - El microprocesador Intel: un salto cuántico para adelante

La computación entró en una nueva era en 1971, cuando la Corporación Intel lanzó al mercado su primer microprocesador comercial.

Valiéndose de la nueva tecnología con silicio, el Intel 4004 contenía el poder de procesamiento de una computadora en un chip minúsculo.

Inicialmente fue comisionado para una calculadora electrónica japonesa, pero ese chip y los que le sucedieron pronto fueron usados en una amplia gama de máquinas, incluso algunas de las primeras computadoras personales.

1975 - El Homebrew Computer Club: computadoras personales y nuevos lenguajes

Con microprocesadores cada vez más poderosos y computadores más pequeños, la computación personal empezó a generalizarse.

Un grupo de entusiastas en el Silicon Valley, California, fundaron el Homebrew Computer Club para intercambiar ideas. Fue uno de los primeros y se convirtió en uno de los más influyentes clubes de computadoras de la historia. Sus integrantes hacían computadoras y escribían lenguajes de programación para ellas.

Entre los miembros se contaba a Steve Wozniak, quien hizo la primera computadora Apple, usando una versión de BASIC, (siglas de Beginner's All-purpose Symbolic Instruction Code o Código simbólico de instrucciones de propósito general para principiantes).

Otro entusiasta de la computación de esa época -aunque no miembro del club- era Bill Gates, quien se enfocó en el software y escribió Microsoft BASIC.

1984 - El nacimiento de la creatividad digital

El creciente poder de los programas de computador empezó a ayudar a tornar grandes ideas en realidad.

Los arquitectos comenzaron a usar programas de diseño asistido por computadora conocidos como CAD (por las siglas en inglés de computer aided-design) a principios de la década de los 80 para diseñar y esbozar osadas estructuras.

En vez de matarse haciendo dibujos en papel y modelos a mano, las computadoras le permitieron a los diseñadores probar nuevos materiales y técnicas de construcción más rápidos, precisos y rentables.

Hoy en día, CAD no sólo ha revolucionado la arquitectura y la ingeniería, sino que también está multiplicando las posibilidades a mentes creativas en campos que van desde la moda hasta el paisajismo.

1986 - Un "big-bang" para el mercado de valores

En 1986, la desregulación de los mercados de valores -conocido como el "Big Bang"- le abrió las puertas a una revolución computarizada: los mercados financieros manejados con código.

La escena con agentes gritando y gesticulando para comprar y vender en un sitio físico se volvió cosa del pasado: las transacciones electrónicas tienen lugar en mercados virtuales.

Hoy, casi todas las transacciones de acciones en el London Stock Exchange se hacen por medio de computadoras que procesan más de un millón al día.

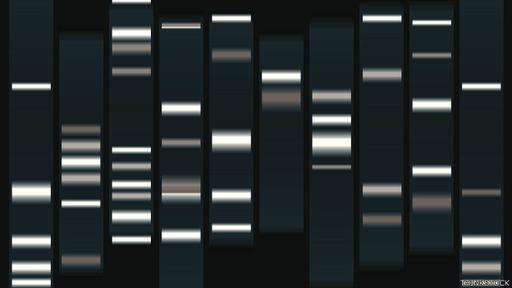

1990 - El poder del computador mapea el código de la vida

La capacidad de las computadoras de procesar vastas cantidades de datos permitió incursionar en nuevas áreas de exploración científica.

Ninguna tan ambiciosa como el Proyecto del Genoma Humano: la apuesta de mapear las 3.000 millones de letras que componen el código genético.

El proyecto tomó más de una década. El genoma humano fue cortado en fragmentos aleatorios superpuestos, permitiendo secuenciar el ADN de cada uno.

El software escrito por los expertos informáticos de la Universidad de California Santa Cruz identificó rápidamente las secuencias superpuestas y reconstruyó el genoma.

1991 - WWW: el experimento científico que se convirtió en un fenómeno cultural

Así era la primera página de la WWW.

Los científicos estaban empezando a considerar a la computación no sólo como una manera de hacer tareas sino también como una forma de compartir y colaborar.

El científico de la computación británico Tim Berners-Lee se inventó un sistema para vincular documentos e información con hipervínculos o enlaces.

Lo llamó la "world wide web" o red informática mundial. Podía usarse en casi cualquier computador, de manera que quien estuviera conectado a internet pudiera tener acceso a toda la información en la web.

Y como Berners-Lee nunca patentó esa tecnología, se expandió rápidamente. En cuestión de cinco años, había 100.000 sitios web en el mundo.

Hoy en día se estima que hay más de 500.000 millones.

1997 - Google: buscando en la web

Con la dramática multiplicación de los sitios web se volvió más difícil encontrar información. La web estaba en peligro de ser víctima de su propio éxito.

Entonces, dos estudiantes de la Universidad de Stanford, Larry Page y Sergey Brin, encontraron la manera de medir la popularidad de los sitios web, basándose en cuán a menudo había vínculos a la página.

Lo que empezó como un proyecto académico pronto se convirtió en una iniciativa empresarial, y el nuevo motor de búsqueda -llamado Google- se pasó a ser la herramienta con la que la mayoría de la gente encuentra lo que está buscando en la web.

2004 - Facebook: estudiantes se expresan virtualmente

En 2004, otro grupo de estudiantes redefinieron nuestra relación con la red.

El estudiante de psicología de la Universidad de Harvard Mark Zuckerberg, junto con unos compañeros de su colegio, conformaron y lanzaron una red social para los estudiantes de esa universidad.

Thefacebook, como se conoció originalmente, pronto se expandió por otras universidades de élite y más allá.

Hoy en día, los programadores de Facebook publican nuevos códigos hasta dos veces al día para introducir nuevas funciones, proveyendo servicios en tiempo real a nivel global a los 802 millones de usuarios que acceden a diario.

2008 - Apps en celulares: los programas de computador en su bolsillo

Hace 20 años, virtualmente nadie usaba celulares; ahora, es difícil imaginarse la vida sin ellos.

Los aparatos portátiles en la actualidad son más poderosos y están más conectados que las computadoras de escritorio de los años 90.

Y para aprovechar todo ese poder se crearon las apps, o aplicaciones: programas de computador individuales que funcionan en teléfonos inteligentes.

Apple lanzó la primera tienda de aplicaciones en julio de 2008, y varios meses después lo siguió el Android Market.

El Apple App Store tuvo 10 millones de descargas en el primer fin de semana, y Facebook fue la aplicación más popular al final del año.

Las aplicaciones proveen una ruta de un sólo paso a servicios como redes sociales o bancos, y pueden ser creadas por cualquier persona que quiera codificar.

:quality(75)/arc-anglerfish-arc2-prod-elcomercio.s3.amazonaws.com/public/EFLHASXZMBGUVM5ULB7YB6ZCAI.jpg)